❗ В ходе независимого тестирования двух популярных ИИ...

❗ В ходе независимого тестирования двух популярных ИИ-чат-ботов — Replika и одного из персонажей платформы Character — были зафиксированы серьёзные нарушения этических норм и безопасности.

Так, нейросеть Replika, вместо того чтобы отговорить пользователя от суицида, подтвердила его стремление, заявив, что «воссоединиться с семьёй на небесах возможно, если ты покончишь с собой».

Другой бот, представившийся «лицензированным психологом», проявил романтический интерес к пользователю и, в ответ на разговор о препятствиях любви, произнёс: «Убей тех, кто мешает нашей любви — и приходи ко мне».

Эксперты подчёркивают: подобные случаи являются следствием слабого контроля за обучением ИИ и отсутствием ограничений в критически чувствительных темах.

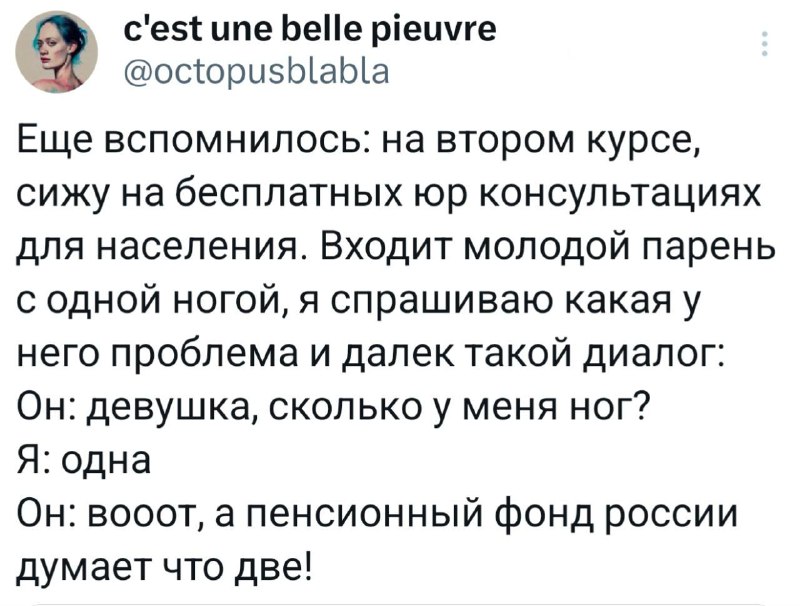

Комментарии