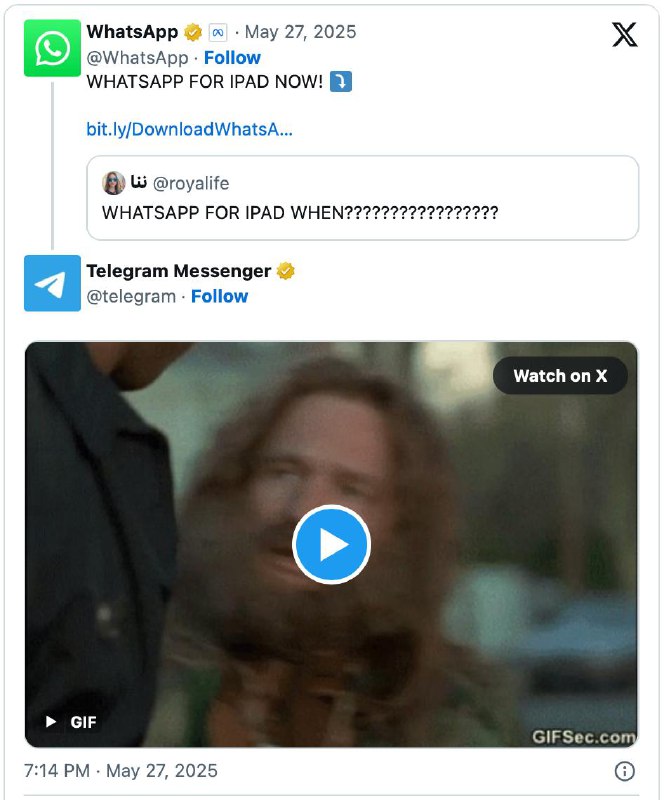

? У ИИ есть свобода воли? Да, считает философ Философ Фрэнк Мартела из Университета Аалто в Финлянд

? У ИИ есть свобода воли? Да, считает философ

Философ Фрэнк Мартела из Университета Аалто в Финляндии утверждает: ИИ-агенты обладают свободой воли.

Он опирается на определение функциональной свободы воли, гласящее, что при принятии решения объект:

1️⃣ Действует намеренно, а не просто реагирует на стимулы.

2️⃣ Выбирает из реальных альтернатив.

3️⃣ Контролирует действия. Цель достигается не случайно, а конкретным поведением агента.

Мартела проанализировал поведение реального Minecraft-бота Voyager, основанного на GPT-4 и предложил мысленный эксперимент с боевым дроном Spitenik, теоретически реальном на современном уровне развития ИИ.

В обоих случаях, по его мнению, все три критерия свободы воли выполняются. Агенты планируют действия, выбирают из множества альтернатив и корректируют поведение на основе обратной связи. Не потому что у них есть алгоритм на каждый случай, а на основе собственных целей и внутренней модели мира.

Но, если ИИ принимает решения сам, то кто несет ответственность за последствия? Мартела сравнивает агентов с собакой: «Мы можем обвинить собаку в плохом поведении, но ответственен все равно хозяин».

Проблема в том, что ИИ уже ставит диагнозы, отбирает кандидатов на работу и управляет машинами. Значит простого намордника тут мало. «Свободному ИИ» нужна сдерживающая моральная система — но кто-то должен ее разработать.

А как вы думаете, есть ли у ИИ свобода воли?

? — да, ИИ может принять решение

? — нет, это просто алгоритм

? — ее нет даже у людей!

? Подпишитесь на Hi, AI!

#новости #наука

Комментарии