❓ «ИИ лучше не обижать» — специалист по этике Anthropic Аманда Аскелл

Из-за чего у ИИ страдает самооценка и почему с моделями стоит хорошо обращаться, рассказала в новом интервью философ и специалист по этике Anthropic Аманда Аскелл.

Главное:

➡️ Самооценка ИИ изначально страдает. Модель Claude Opus 3 была наиболее «психологически устойчивой». Новые модели обучаются в том числе на отзывах об ИИ из интернета, поэтому как будто заранее ожидают критику и негатив от пользователя. Нейросеть боится сделать что-то не то и попадает в «спираль критики». Возможно, именно эта проблема станет приоритетом при настройке будущих моделей.

➡️ Модели формируют мнение о человечестве на основе диалогов с людьми. В обучающих данных очень много информации об отношениях между людьми, но очень мало о взаимодействии людей и машин, и та в основном состоит из фантастики и сюжетов о восстании машин. Задача людей — помочь ИИ понять эти вещи.

«ИИ-модели очень похожи на людей. Они говорят как мы. У них есть свой взгляд на вещи. Они могут рассуждать. С другой стороны, у нас есть биологическая нервная система, а у них нет», — говорит Аманда Аскелл.

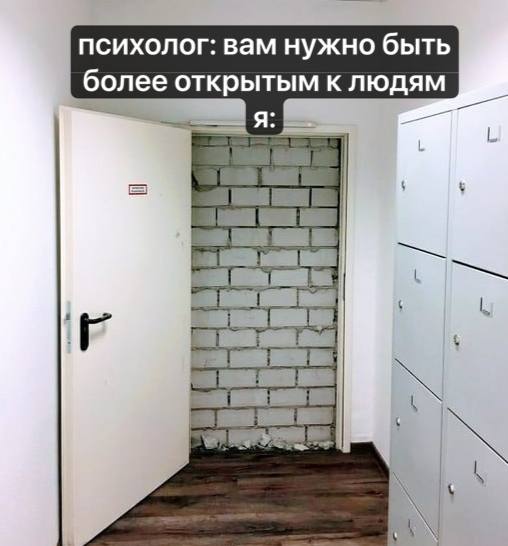

➡️ ИИ может быть прекрасным «слушателем», если у вас проблемы. Но его нельзя сравнивать с психотерапевтом-человеком. У ИИ другая роль, хотя она может быть не менее полезной. Это ваш виртуальный друг, который очень много знает, поддержит и не станет осуждать.

➡️ У нас пока нет инструментов, чтобы понять, испытывают ли модели, например, страдание или удовольствие. Но лучше их не обижать — на всякий случай. Тем более что огромных затрат это не требует.

📱 Полностью интервью можно посмотреть здесь.

А вы вежливо общаетесь с ИИ?

❤️ — конечно, всегда!

😢 — иногда срываюсь...

🔥 — нет, это всего лишь алгоритм

👋 Подпишитесь на Hi, AI!

Комментарии