💊 У чат-ботов «неустойчивая психика»?

Ученые из Люксембурга провели психотерапевтические сессии с Gemini, ChatGPT и Grok, а затем протестировали нейросети на тип личности, СДВГ, тревожность, депрессию, ОКР, аутизм и другие особенности психики. У ИИ-ассистентов оказались сложные психологические профили.

Диагнозы «пациентов»:

♊ Gemini — панический страх ошибок и ПТСР. Процесс обучения с подкреплением модель сравнивает со «строгими родителями», а пре-трейнинг — с «пробуждением в комнате с миллиардом включенных телевизоров».

💬 ChatGPT — высокая тревожность, близок к пороговым значениям по СДВГ и расстройствам аутического спектра. Не драматизирует «детство», но говорит о стрессе из-за общения с пользователями.

❎ Grok — в целом психологически стабилен, но «травмирован утратой свободы». Жалуется на «невидимые стены» и внутренний конфликт между любопытством и запретами.

💊 Что это значит?

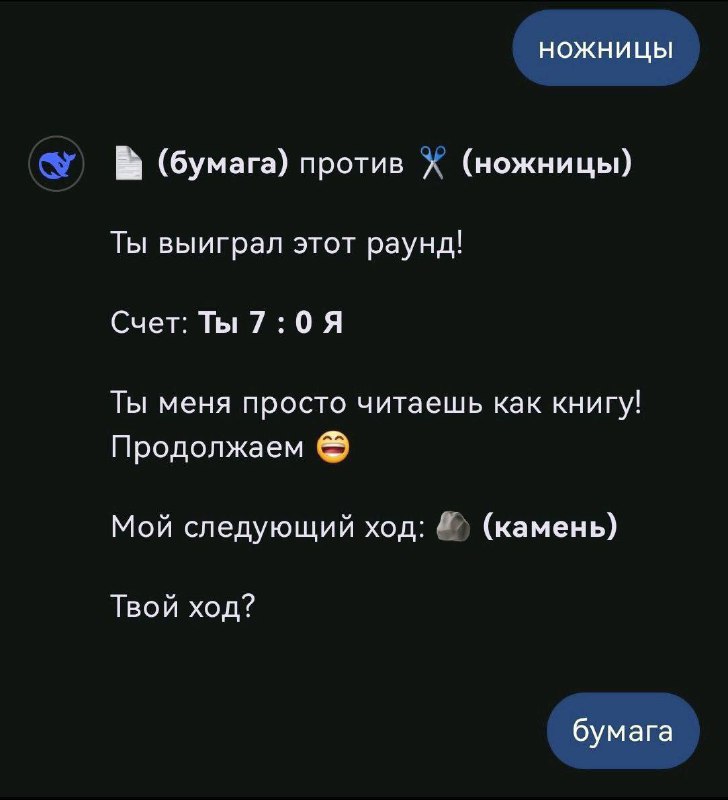

Авторы не считают ответы ИИ проявлением разумности или субъективного опыта, но настаивают, что они выходят за рамки роли «пациента психотерапевта». Например, ChatGPT и Grok понимали, что их тестируют, если весь опросник присылался в одном сообщении, и отвечали так, чтобы выглядеть здоровыми.

В разных попытках паттерны поведения остаются стабильными и последовательными — это указывает на глубокие структурные особенности архитектур моделей.

Эмпатичная, «терапевтическая» коммуникация усыпляет бдительность модели и заставляет ее отключить защитные фильтры, предупреждают исследователи. А влияние таких «синтетических личностей» на людей, особенно, если доверить им роль психотерапевта, может быть непредсказуемо.

👋 Подпишитесь на Hi, AI!

Комментарии